Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

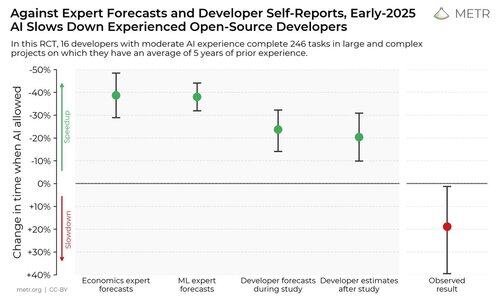

Am efectuat un studiu controlat randomizat pentru a vedea cât de mult instrumentele de codare AI accelerează dezvoltatorii open-source cu experiență.

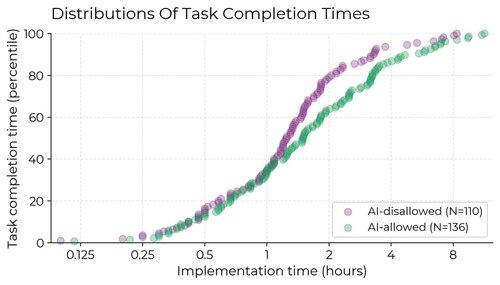

Rezultatele ne-au surprins: dezvoltatorii au crezut că sunt cu 20% mai rapizi cu instrumentele AI, dar de fapt au fost cu 19% mai lenți atunci când au avut acces la AI decât atunci când nu au avut.

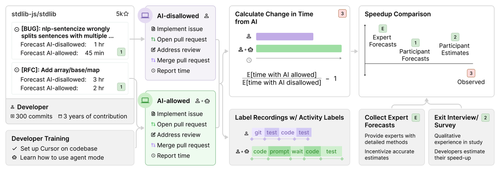

Am recrutat 16 dezvoltatori open-source cu experiență pentru a lucra la 246 de sarcini reale în propriile depozite (medie 22k+ stele, 1M+ linii de cod).

Am alocat aleatoriu fiecare sarcină fie pentru a permite AI (de obicei Cursor Pro cu Claude 3.5/3.7), fie pentru a interzice ajutorul AI.

La începutul studiului, dezvoltatorii au prognozat că vor fi accelerați cu 24%. După ce au făcut efectiv munca, au estimat că au fost accelerați cu 20%. Dar s-a dovedit că au fost de fapt încetinite cu 19%.

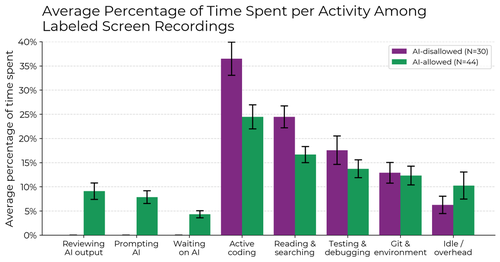

Când AI este permisă, dezvoltatorii petrec mai puțin timp codând și căutând informații în mod activ și, în schimb, petrec timp solicitând AI, așteptând / revizuind rezultatele AI și inactiv. Nu găsim un singur motiv pentru încetinire – este determinată de o combinație de factori.

De ce am efectuat acest studiu?

Benchmark-urile agenților AI au limitări - sunt autonome, folosesc scoruri algoritmice și nu au interacțiune umană live. Acest lucru poate face dificilă deducerea directă a impactului în lumea reală.

Dacă vrem un sistem de avertizare timpurie pentru a stabili dacă cercetarea și dezvoltarea AI este accelerată de AI însăși sau chiar automatizată, ar fi util să putem măsura direct acest lucru în testele inginerilor din lumea reală, mai degrabă decât să ne bazăm pe proxy precum benchmark-uri sau informații chiar mai zgomotoase, cum ar fi anecdote.

Ce reținem?

1. Pare probabil că, pentru unele setări importante, instrumentele recente AI nu au crescut productivitatea (și chiar o pot scădea).

2. Auto-rapoartele de accelerare nu sunt fiabile – pentru a înțelege impactul AI asupra productivității, avem nevoie de experimente în sălbăticie.

401,38K

Limită superioară

Clasament

Favorite