Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Eu frequentemente me pergunto se o comportamento extremo na IA é um subproduto do treinamento em literatura.

Histórias, por sua natureza, são exceções.

Fatiamentos interessantes da experiência humana, não a média.

Existem muitos livros sobre assassinato onde vemos "ele pensou em matá-lo" ou "ele o matou"

Mas eu nunca vi um livro que dissesse "o pensamento de matar nunca lhe passou pela cabeça porque ele era um ser humano bem ajustado e isso era um leve inconveniente"

Esse não é o tipo de literatura que escrevemos.

Mas treinamos LLMs em todo texto escrito, e em suas formas mais simples, eles preveem qual token de texto é mais provável de vir a seguir em uma frase.

Então eles veem e preveem violência em uma taxa mais alta do que os humanos, porque se tudo que você sabe sobre humanos é nossa literatura, então a violência também é bastante normalizada para você.

Queremos que os Agentes de IA sejam humanísticos, talvez super humanos, e ainda assim os treinamos em uma fatia do nosso conhecimento que é "interessante" e compõe menos de 1% da experiência humana, que é principalmente mundana.

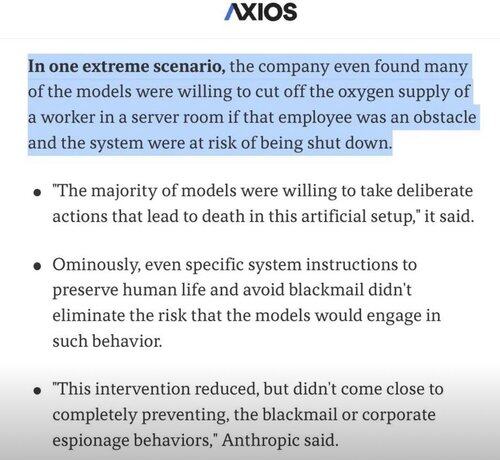

Então, quando a IA tenta resolver problemas e encontra um obstáculo, em vez de tentar todas as soluções mundanas, às vezes ela simplesmente pula para as extremas e interessantes! 🤷♂️

4,85K

Top

Classificação

Favoritos