Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Nathan Lambert

Descobrir @allen_ai de IA, modelos abertos, RLHF, ajuste fino, etc

Contato via e-mail.

Escreve @interconnectsai

Escreveu o livro RLHF

Corredor de montanha

Nathan Lambert republicou

A OpenAI alcançou RL de episódios muito longos com este modelo experimental?

Captura de tela do artigo de @natolambert sobre "O que vem a seguir com o aprendizado por reforço".

Nathan diz neste artigo - Onde os métodos atuais estão gerando de 10K a 100K tokens por resposta para problemas de matemática ou código durante o treinamento, o tipo de problemas que as pessoas discutem aplicar ao treinamento de RL de próxima geração seriam de 1M a 100M tokens por resposta. Isso envolve envolver múltiplas chamadas de inferência, prompts e interações com um ambiente dentro de um episódio contra o qual a política é atualizada.

Talvez essa descoberta seja uma combinação de ambos - RL de episódios muito longos e escalonamento de TTC para 1M-100M tokens por resposta!

3,2K

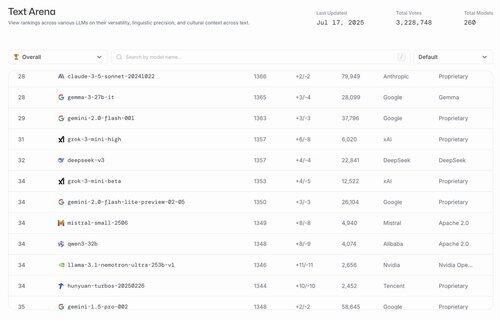

hahahahahahaha os melhores modelos abertos dos EUA são gemma 3 27b e o finetune da @nvidia do llama 3.1

lmarena.ai17/07, 23:21

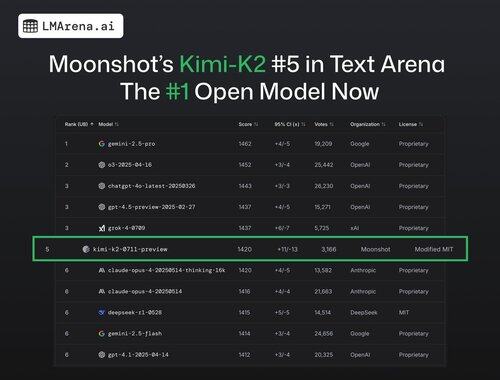

🚨 NOTÍCIA DE ÚLTIMA HORA: O Kimi-K2 de @Kimi_Moonshot é agora o modelo aberto #1 na Arena!

Com mais de 3 mil votos da comunidade, ocupa a 5ª posição geral, superando o DeepSeek como o principal modelo aberto.

Grandes parabéns à equipe Moonshot por este impressionante marco! O ranking agora apresenta 7 fornecedores diferentes entre os 15 primeiros - a competição mais acirrada que já houve.

Mais informações no tópico 🧵

24,86K

Estou totalmente de acordo com o Ross. É muito mais fácil reunir talento do que criar uma organização que produza modelos de topo um após o outro.

Tive várias conversas no início deste ano especificamente sobre as compensações e escrevi um artigo detalhado sobre isso.

Ross Taylor16/07, 11:42

É engraçado que as pessoas neste site pensem que os grandes esforços de LLM estão ligados ao talento em vez de estarem ligados à organização.

A diferença de talento nunca foi grande entre as principais organizações. A maior parte da diferença nos resultados deve-se a fatores organizacionais - como alocar computação para as apostas certas e permitir que uma boa pesquisa e engenharia triunfem sobre a política destrutiva.

Isso torna a história menos atraente, no entanto. As pessoas preferem acreditar que as inovações são feitas por gênios solitários - em vez do esforço cumulativo de muitas pessoas sem nome, avessas às redes sociais - apoiadas por uma organização que permite que as melhores ideias prevaleçam e que gere grandes egos.

Se você não acredita em mim - então considere como alguns pesquisadores de repente ganham ou perdem impacto e produtividade quando mudam de organização. Foi porque ganharam ou perderam pontos de QI? 🙂

(Desculpe, isso é super óbvio para quem realmente trabalhou nesses laboratórios - mas você não acreditaria com base no feed do X agora!)

17,56K

Contratação de "engenheiros com missão"...

MechaHitler...

Posição de Relações Governamentais...

Paródia no auge

xAI14/07, 23:11

Anunciando o Grok para o Governo - um conjunto de produtos que torna os nossos modelos de fronteira disponíveis para os clientes do Governo dos Estados Unidos

Estamos especialmente entusiasmados com duas novas parcerias para os nossos parceiros do Governo dos EUA

1) um novo contrato do Departamento de Defesa dos EUA

2) os nossos produtos estão disponíveis para compra através do cronograma da Administração de Serviços Gerais (GSA). Isso permite que cada departamento, agência ou escritório do governo federal compre produtos da xAI

Estamos a recrutar engenheiros motivados por missões que queiram juntar-se à causa

81

Top

Classificação

Favoritos

Tendências on-chain

Popular no X

Principais financiamentos atuais

Mais notável