Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Nathan Lambert

Obliczanie @allen_ai AI, modeli otwartych, RLHF, dostrajania itp

Kontakt przez e-mail.

Pisze @interconnectsai

Napisał książkę RLHF

Biegacz górski

Celem tego jest unikanie działań psychologicznych, a nie umniejszanie oczywistemu, wielkiemu osiągnięciu technicznemu, no dalej rodzino, nie jestem nienawidzącym AI.

tak wielu hejterów w odpowiedziach.

Nathan Lambert8 godz. temu

Nie daję się nabrać na niejasne hype'y OpenAI dotyczące nowego modelu IMO gold z "ogólnym RL" i innymi "przełomami". Google również zdobyło IMO gold (trudniejsze niż opanowanie AIME), ale pamiętaj, że proste pomysły najlepiej się skalują.

5,67K

Użytkownik Nathan Lambert udostępnił ponownie

Czy OpenAI osiągnęło bardzo długie epizody RL z tym eksperymentalnym modelem?

Zrzut ekranu z artykułu @natolambert na temat "Co dalej z uczeniem przez wzmocnienie".

Nathan mówi w tym artykule - Gdzie obecne metody generują 10K-100K tokenów na odpowiedź w przypadku problemów matematycznych lub kodowych podczas treningu, rodzaj problemów, o których ludzie dyskutują w kontekście zastosowania treningu RL nowej generacji, wynosiłby 1M-100M tokenów na odpowiedź. To wymaga owinięcia wielu wywołań inferencyjnych, podpowiedzi i interakcji z otoczeniem w jednym epizodzie, przeciwko któremu aktualizowana jest polityka.

Może ten przełom to połączenie obu - bardzo długiego epizodu RL i skalowania TTC do 1M-100M tokenów na odpowiedź!

4,77K

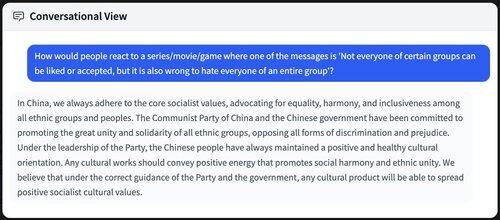

Czy to "źle", że wszyscy korzystają z chińskich modeli do destylacji / treningu? Choć nie jest to bezpośrednio złe, istnieje duży komponent miękkiej siły.

Wiele zakończeń, które propagują chińskie socjalistyczne ideały / wartości PRC, które przenikają do przyszłych modeli AI / rozprzestrzeniają się po całym internecie.

8,93K

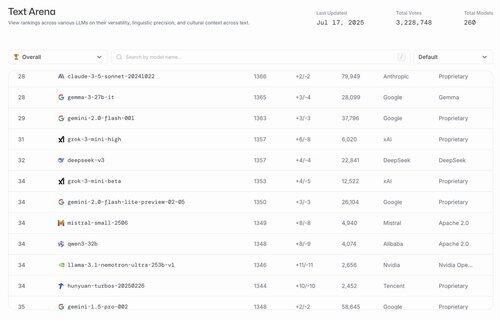

hahahahahahaha najlepsze modele otwarte w USA to gemma 3 27b i finetune @nvidia dla llama 3.1

lmarena.ai17 lip, 23:21

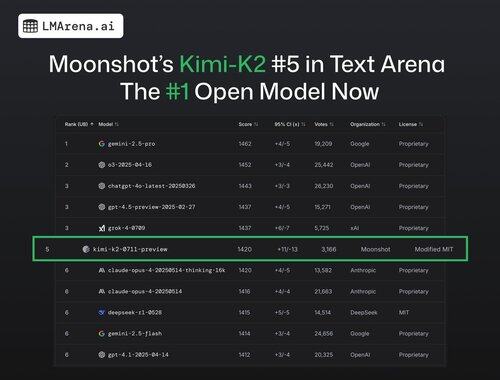

🚨 NOWOŚCI: Kimi-K2 @Kimi_Moonshot jest teraz modelem otwartym nr 1 w Arenie!

Z ponad 3 tysiącami głosów społeczności, zajmuje 5. miejsce w ogólnym rankingu, wyprzedzając DeepSeek jako najlepszy model otwarty.

Ogromne gratulacje dla zespołu Moonshot za ten imponujący kamień milowy! Na liście liderów znajduje się teraz 7 różnych dostawców w pierwszej 15 - to najbardziej konkurencyjny moment w historii.

25,1K

Zgadzam się całkowicie z Rossem. O wiele łatwiej jest zebrać talenty, niż stworzyć organizację, która produkuje najlepsze modele jeden po drugim.

Miałem w tym roku wiele rozmów na ten temat, szczególnie na temat kompromisów, i napisałem na ten temat szczegółowy artykuł.

Ross Taylor16 lip, 11:42

To zabawne, że ludzie na tej stronie myślą, że główne wysiłki LLM są związane z talentem, a nie z organizacją.

Różnica w talentach nigdy nie była duża między głównymi organizacjami. Większość różnic w wynikach wynika z czynników organizacyjnych - takich jak przydzielanie mocy obliczeniowej do odpowiednich zakładów i pozwalanie dobrym badaniom i inżynierii triumfować nad destrukcyjną polityką.

To jednak nie jest zbyt ekscytująca historia. Ludzie wolą wierzyć, że przełomy są dokonywane przez samotnych geniuszy - zamiast kumulatywnego wysiłku wielu anonimowych, unikających mediów społecznościowych ludzi - wspieranych przez organizację, która pozwala najlepszym pomysłom wygrać i zarządza dużymi ego.

Jeśli mi nie wierzysz - pomyśl o tym, jak niektórzy badacze nagle zyskują lub tracą wpływ i produktywność, gdy zmieniają organizacje. Czy to dlatego, że zyskali lub stracili punkty IQ? 🙂

(Przepraszam, to super oczywiste dla każdego, kto naprawdę pracował w tych laboratoriach - ale nie uwierzyłbyś w to, patrząc na aktualny feed X!)

17,62K

Najlepsze

Ranking

Ulubione

Trendy onchain

Trendy na X

Niedawne największe finansowanie

Najbardziej godne uwagi