Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Andrej Karpathy

Budynek @EurekaLabsAI. Wcześniej dyrektor AI @ Tesla, zespół założycielski @ OpenAI, CS231n/PhD @ Stanford. Lubię trenować duże, głębokie sieci neuronowe 🧠🤖💥

Modele wideo oparte na dyfuzji, ale teraz - **w czasie rzeczywistym**!

Proste filtry wideo działają w czasie rzeczywistym, ale mogą jedynie wykonywać podstawowe zmiany kolorów i style. Modele dyfuzji wideo (Veo i przyjaciele) to magia, ale generują obrazy przez wiele sekund/minut. MirageLSD to magia w czasie rzeczywistym. W przeciwieństwie do prostych filtrów wideo, modele dyfuzji rzeczywiście *rozumieją*, co widzą, więc mogą inteligentnie stylizować wszystkie części strumienia (np. zakładając kapelusze na głowy lub miecze świetlne do rąk itd.). I są dowolnie kierowane, np. za pomocą tekstowych podpowiedzi.

Dostosowywalne, inteligentne filtry wideo odblokowują wiele fajnych pomysłów w czasie:

- przekształcanie strumieni z kamer w alternatywne rzeczywistości

- reżyserowanie i kręcenie własnych filmów, odgrywając sceny z rekwizytami. Czas rzeczywisty => natychmiastowa informacja zwrotna/recenzja.

- kodowanie gier w stylu vibe wokół prostych sfer/klocków, a następnie użycie modelu dyfuzji w czasie rzeczywistym do teksturowania gry, aby uczynić ją piękną.

- stylizowanie i dostosowywanie dowolnego strumienia wideo: gry, filmy, ... np. Skyrim, ale "BARDZIEJ EPICKI"? DOOM II, ale nowoczesna jakość Unreal Engine tylko za pomocą podpowiedzi? Film grozy, ale "słodki, różowy i tylko króliki"? Nie wiem!

- tła do rozmów wideo+++

- wirtualne przymierzanie ubrań w czasie rzeczywistym

- okulary: np. czy można w czasie rzeczywistym zamienić swoją wizję w kreskówkę?

- teraz możemy zbudować Lustro Erised z Harry'ego Pottera, pokazujące "surowy strumień" ciebie w lustrze, ale wzbogacone o twoje najgłębsze pragnienia (jak to zinterpretowała AI).

- Nie wiem, prawdopodobnie pomijam największą rzecz, tyle możliwości!

Decart18 lip, 04:44

Przedstawiamy MirageLSD: Pierwszy model AI do dyfuzji na żywo (LSD)

Wprowadź dowolny strumień wideo, od kamery lub czatu wideo po ekran komputera lub grę, i przekształć go w dowolny świat, który pragniesz, w czasie rzeczywistym (<40ms opóźnienia).

Oto jak to działa (z demonstracją, której możesz użyć!) :

326,63K

Często narzekam na to, że 99% uwagi będzie dotyczyć uwagi LLM, a nie ludzkiej. Jak wygląda praca badawcza dla LLM zamiast dla człowieka? To zdecydowanie nie jest pdf. Istnieje ogromna przestrzeń na niezwykle cenną "aplikację badawczą", która to ustali.

Michael Levin10 lip, 22:47

Ciągle mnie irytuje, że nie mam czasu na przeczytanie strumienia świetnych artykułów, które napływają coraz szybciej od niesamowitych ludzi w odpowiednich dziedzinach. Inni naukowcy mają ten sam problem i również nie mają czasu na przeczytanie większości moich długich artykułów koncepcyjnych. Więc dla kogo piszemy te artykuły?

Myślę, że przynajmniej do momentu, gdy sami nie napotkają tego samego problemu w swojej pracy, AI będą jedynymi, którzy naprawdę będą mieli czas na przeczytanie tych wszystkich rzeczy. Nie mówię tu konkretnie o dzisiejszych modelach językowych - załóżmy, że mamy na myśli jakiekolwiek nieuchronne AI, które się pojawi, zdolne do czytania literatury i wpływania na badania (czy to poprzez rozmowę z ludźmi, czy poprzez uruchamianie automatyzacji laboratorium/platform robotów naukowych).

Więc jak powinniśmy pisać, wiedząc, że wielu naszych odbiorców będzie AI (plus cyborgi, hybrydy, ludzie z rozszerzoną rzeczywistością itp.)? Może jest za wcześnie, aby wiedzieć, co robić, ale lepiej zacząć o tym myśleć, ponieważ zakładanie, że naszym odbiorcą zawsze będą dzisiejsi ludzie, wydaje się nie do utrzymania. Biorąc na poważnie pomysł, że pewnego dnia wpływowa publiczność będzie bardzo różna, a to, co piszemy teraz, jest w pewnym sensie zestawem treningowym dla naprawdę różnorodnych przyszłych istot, jak zmienia się nasze pisanie? A może się nie zmienia?

498,05K

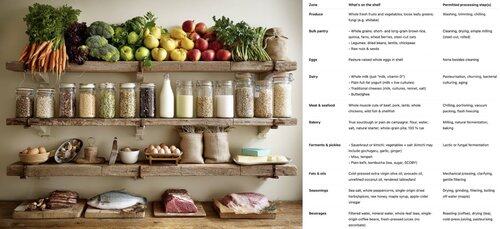

Jak zbudować rozwijającą się społeczność open source, pisząc kod jak bakterie 🦠. Kod bakteryjny (genomy) jest:

- mały (każda linia kodu kosztuje energię)

- modułowy (zorganizowany w grupy wymiennych operonów)

- samodzielny (łatwy do "kopiowania i wklejania" dzięki poziomemu transferowi genów)

Jeśli kawałki kodu są małe, modułowe, samodzielne i łatwe do skopiowania i wklejenia, społeczność może rozwijać się dzięki poziomemu transferowi genów. Dla każdej funkcji (genu) lub klasy (operonu), którą piszesz: czy możesz sobie wyobrazić, że ktoś mówi "yoink" bez znajomości reszty twojego kodu lub konieczności importowania czegokolwiek nowego, aby uzyskać korzyść? Czy twój kod mógłby być popularnym gistem na GitHubie?

Ten przewodnik po stylu kodowania pozwolił bakteriom skolonizować każdy ekologiczny zakątek, od zimnego do gorącego, od kwaśnego do zasadowego, w głębinach Ziemi i w próżni kosmosu, wraz z niesamowitą różnorodnością anabolizmu węgla, metabolizmu energetycznego itd. Doskonale nadaje się do szybkiego prototypowania, ale... nie potrafi zbudować złożonego życia. W porównaniu do tego, genom eukariotyczny jest znacznie większy, bardziej złożony, zorganizowany i połączony monorepo. Znacznie mniej pomysłowy, ale niezbędny do złożonego życia - do budowania całych organów i koordynowania ich aktywności. Dzięki naszej przewadze inteligentnego projektowania, powinno być możliwe wykorzystanie obu. Zbuduj monorepo eukariotyczne, jeśli musisz, ale maksymalizuj DNA bakteryjne.

538,7K

Wyścig o "kognitywne jądro" LLM - model z kilkoma miliardami parametrów, który maksymalnie poświęca encyklopedyczną wiedzę na rzecz zdolności. Żyje zawsze włączony i domyślnie na każdym komputerze jako jądro osobistego przetwarzania LLM.

Jego cechy powoli się krystalizują:

- Natywna multimodalność tekstu/wizji/dźwięku zarówno na wejściu, jak i wyjściu.

- Architektura w stylu matrioszki, pozwalająca na regulację zdolności w górę i w dół w czasie testu.

- Rozumowanie, również z regulacją. (system 2)

- Agresywne korzystanie z narzędzi.

- Sloty LoRA do dostrajania na urządzeniu na potrzeby treningu w czasie testu, personalizacji i dostosowywania.

- Deleguje i podwójnie sprawdza tylko te odpowiednie części z oraklami w chmurze, jeśli internet jest dostępny.

Nie wie, że panowanie Wilhelma Zdobywcy zakończyło się 9 września 1087 roku, ale w pewnym sensie rozpoznaje to imię i może sprawdzić datę. Nie potrafi recytować SHA-256 pustego ciągu jako e3b0c442..., ale może to szybko obliczyć, jeśli naprawdę tego chcesz.

Czego osobiste przetwarzanie LLM brakuje w szerokiej wiedzy o świecie i najwyższej klasy zdolności rozwiązywania problemów, to nadrobi w super niskiej latencji interakcji (szczególnie w miarę dojrzewania multimodalności), bezpośrednim / prywatnym dostępie do danych i stanu, offline'owej ciągłości, suwerenności ("nie twoje wagi, nie twój mózg"). tzn. wiele z tych samych powodów, dla których lubimy, używamy i kupujemy komputery osobiste zamiast mieć cienkie klienty uzyskujące dostęp do chmury przez zdalny pulpit lub coś w tym stylu.

1,03M

Najlepsze

Ranking

Ulubione

Trendy onchain

Trendy na X

Niedawne największe finansowanie

Najbardziej godne uwagi