Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Andrej Karpathy

Gebouw @EurekaLabsAI. Voorheen directeur van AI @ Tesla, oprichtend team @ OpenAI, CS231n/PhD @ Stanford. Ik train graag grote diepe neurale netwerken 🧠🤖💥

Diffusie videomodellen maar nu - **realtime**!

Eenvoudige videofilters zijn realtime maar kunnen alleen basis herkleuring en stijlen doen. Videodiffusiemodellen (Veo en vrienden) zijn magie, maar ze hebben vele seconden/minuten nodig om te genereren. MirageLSD is realtime magie. In tegenstelling tot eenvoudige videofilters begrijpen diffusie modellen eigenlijk *wat* ze bekijken, zodat ze alle delen van de feed intelligent kunnen stylen (bijv. hoeden op hoofden zetten, of lichtzwaarden in handen, enz.). En ze zijn willekeurig stuurbaar, bijv. door tekstprompts.

Aanpasbare, intelligente videofilters ontgrendelen in de loop van de tijd veel coole ideeën:

- transformeer camerafeeds in alternatieve realiteiten

- regisseer en schiet je eigen films, scènes naspelen met rekwisieten. Realtime => directe feedback/beoordeling.

- vibe code games rond gewoon eenvoudige sferen/blokken, gebruik vervolgens een realtime diffusie model om je spel te textureren en het mooi te maken.

- style en pas elke videofeed aan: games, video's, ... bijv. Skyrim maar "MEER EPISCH"? DOOM II maar moderne Unreal Engine kwaliteit met alleen een prompt? Horrorfilm maar "schattig, roze en alleen konijnen"? Ik weet het niet!

- zoom call achtergronden+++

- realtime virtueel kleren passen

- brillen: bijv. cartoonify je visie in realtime?

- we kunnen nu de Harry Potter Mirror of Erised bouwen, die de "raw feed" van jou in de spiegel toont maar aangevuld met je diepste verlangens (zoals afgeleid door de AI).

- Ik weet het niet, ik mis waarschijnlijk de grootste, zoveel dingen!

Decart18 jul, 04:44

Introductie van MirageLSD: Het Eerste Live-Stream Diffusie (LSD) AI Model

Voer elke videostream in, van een camera of videochat tot een computerscherm of spel, en transformeer het in elke wereld die je wenst, in real-time (<40ms latentie).

Hier is hoe het werkt (met demo die je kunt gebruiken!) :

347,63K

Ik klaag vaak over hoe 99% van de aandacht binnenkort LLM-aandacht zal zijn in plaats van menselijke aandacht. Hoe ziet een onderzoeksartikel eruit voor een LLM in plaats van voor een mens? Het is zeker geen pdf. Er is een enorme ruimte voor een extreem waardevolle "onderzoeksapp" die dit uitzoekt.

Michael Levin10 jul, 22:47

Ik ben constant geïrriteerd dat ik geen tijd heb om de stortvloed aan coole artikelen te lezen die steeds sneller komen van geweldige mensen in relevante vakgebieden. Andere wetenschappers hebben hetzelfde probleem en hebben ook geen tijd om de meeste van mijn lange conceptuele artikelen te lezen. Voor wie schrijven we deze artikelen eigenlijk?

Ik denk dat, tenminste totdat ze in hetzelfde probleem van hun eigen werk terechtkomen, AI's de enigen zullen zijn die daadwerkelijk de capaciteit hebben om al deze dingen te lezen. Ik heb het niet specifiek over de taalmodellen van vandaag - laten we aannemen dat we het hebben over welke onvermijdelijke AI dan ook die opduikt, die in staat is om de literatuur te lezen en impact te hebben op het onderzoek (of het nu door met mensen te praten is of door labautomatisering/robotwetenschapperplatforms te draaien).

Dus dan: hoe zouden we moeten schrijven, wetende dat een groot deel van ons publiek AI zal zijn (plus cyborgs, hybriden, augmented humans, enz.)? Misschien is het te vroeg om te weten wat te doen, maar we moeten er beter over gaan nadenken, omdat het aannemen dat ons publiek altijd de mensen van vandaag zal zijn, onhoudbaar lijkt. Als we het idee serieus nemen dat op een dag het impactvolle publiek heel anders zal zijn, en dat de dingen die we nu schrijven in zekere zin een trainingsset zijn voor werkelijk diverse toekomstige wezens, hoe verandert ons schrijven? Of verandert het niet?

Wat zeggen jullie @danfaggella @mpshanahan @Plinz @blaiseaguera?

498,07K

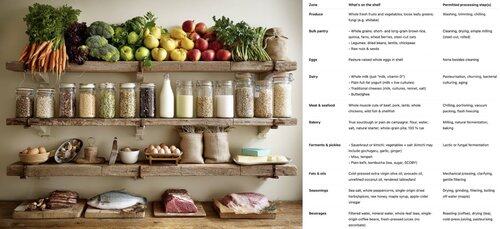

Hoe je een bloeiende open source gemeenschap kunt opbouwen door code te schrijven zoals bacteriën dat doen 🦠. Bacteriële code (genomen) zijn:

- klein (elke regel code kost energie)

- modulair (georganiseerd in groepen verwisselbare operons)

- zelfvoorzienend (gemakkelijk "copy-paste-able" via horizontale genoverdracht)

Als stukken code klein, modulair, zelfvoorzienend en triviaal te kopiëren en plakken zijn, kan de gemeenschap gedijen via horizontale genoverdracht. Voor elke functie (gen) of klasse (operon) die je schrijft: kun je je voorstellen dat iemand "yoink" zegt zonder de rest van je code te kennen of iets nieuws te hoeven importeren, om er voordeel uit te halen? Zou jouw code een trending GitHub gist kunnen zijn?

Deze coderingsstijl heeft bacteriën in staat gesteld om elke ecologische hoek te koloniseren, van koud tot heet, van zuur tot alkalisch, in de diepten van de aarde en de vacuüm van de ruimte, samen met een waanzinnige diversiteit aan koolstofanabolisme, energiemetabolisme, enz. Het excelleert in snelle prototyping, maar... het kan geen complexe levensvormen bouwen. Ter vergelijking: het eukaryote genoom is een aanzienlijk groter, complexer, georganiseerde en gekoppelde monorepo. Aanzienlijk minder inventief, maar noodzakelijk voor complex leven - voor het bouwen van hele organen en het coördineren van hun activiteit. Met ons voordeel van intelligent ontwerp, zou het mogelijk moeten zijn om van beide te profiteren. Bouw een eukaryotische monorepo backbone als je moet, maar maximaliseer bacterieel DNA.

538,72K

De race om de LLM "cognitieve kern" - een model met een paar miljard parameters dat maximaal encyclopedische kennis opgeeft voor capaciteit. Het is altijd aan en standaard op elke computer als de kernel van LLM persoonlijke computing.

De functies kristalliseren langzaam:

- Natuurlijke multimodale tekst/beeld/audio zowel bij invoer als uitvoer.

- Matryoshka-stijl architectuur die een draaiknop voor capaciteit omhoog en omlaag mogelijk maakt tijdens de testfase.

- Redeneren, ook met een draaiknop. (systeem 2)

- Aggressief gebruik van tools.

- On-device finetuning LoRA slots voor training tijdens de testfase, personalisatie en aanpassing.

- Delegeert en controleert alleen de juiste delen met de orakels in de cloud als internet beschikbaar is.

Het weet niet dat de heerschappij van Willem de Veroveraar eindigde op 9 september 1087, maar het herkent de naam vaag en kan de datum opzoeken. Het kan de SHA-256 van een lege string niet opzeggen als e3b0c442..., maar het kan het snel berekenen als je het echt wilt.

Wat LLM persoonlijke computing mist aan brede wereldkennis en topniveau probleemoplossend vermogen, zal het compenseren met super lage interactielatentie (vooral naarmate multimodaal volwassen wordt), directe / privé toegang tot gegevens en status, offline continuïteit, soevereiniteit ("niet jouw gewichten, niet jouw brein"). Met andere woorden, veel van dezelfde redenen waarom we persoonlijke computers leuk vinden, gebruiken en kopen in plaats van dunne clients die via een remote desktop toegang tot de cloud hebben.

1,03M

Boven

Positie

Favorieten

Populair op onchain

Populair op X

Recente topfinanciering

Belangrijkste