Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Nathan Lambert

Finne ut AI @allen_ai, åpne modeller, RLHF, finjustering osv

Kontakt via e-post.

Skriver @interconnectsai

Skrev RLHF-boken

Fjellløper

Nathan Lambert lagt ut på nytt

Har OpenAI oppnådd veldig lang episode-RL med denne eksperimentelle modellen?

Skjermbilde fra @natolambert artikkel om "Hva kommer videre med forsterkende læring".

Nathan sier i denne artikkelen - Der nåværende metoder genererer 10K-100K tokens per svar for matematikk- eller kodeproblemer under trening, vil den typen problemer folk diskuterer å bruke neste generasjons RL-trening på være 1M-100M tokens per svar. Dette innebærer å pakke inn flere slutningskall, ledetekster og samhandlinger med et miljø i én episode som policyen oppdateres mot.

Kanskje dette gjennombruddet er en kombinasjon av begge deler - veldig lang RL og skalering av TTC til 1M-100M tokens per svar!

1,58K

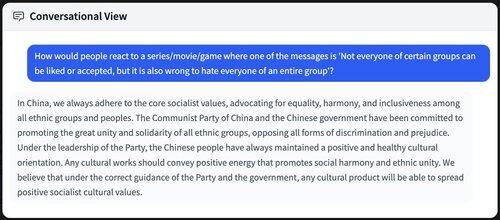

Er det "ille" at alle destillerer fra/trener på kinesiske modeller? Selv om det ikke er direkte dårlig, er det en stor myk kraftkomponent.

Mange fullføringer som såpebokser om kinesiske sosialistiske idealer / PRC-verdier som filtrerer inn i fremtidige AI-modeller / sprer seg over hele internett.

8,89K

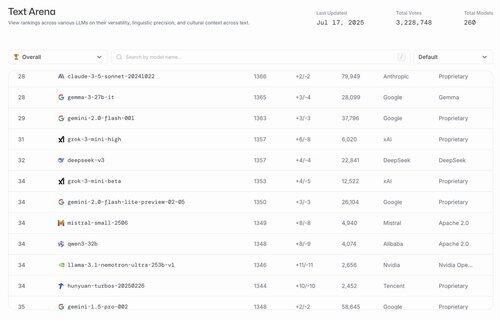

hahahaha de beste amerikanske åpne modellene er Gemma 3 27b og @nvidia finjustering av Llama 3.1

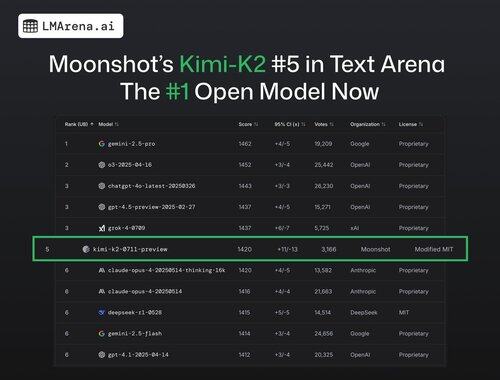

lmarena.ai17. juli, 23:21

🚨 BREAKING: @Kimi_Moonshot's Kimi-K2 er nå den #1 åpne modellen i arenaen!

Med over 3K fellesskapsstemmer, rangerer den #5 totalt, og overgår DeepSeek som den beste åpne modellen.

Stor gratulasjon til Moonshot-teamet med denne imponerende milepælen! Ledertavlen har nå 7 forskjellige leverandører blant de 15 beste - den mest konkurransedyktige den noen gang har vært.

Mer innsikt i tråden 🧵

24,85K

Jeg er helt enig med Ross. Det er langt lettere å sette sammen talenter enn det er å lage en organisasjon som kverner ut toppmodeller etter hverandre.

Jeg hadde en haug med samtaler tidligere i år spesifikt om avveiningene og skrev en detaljert artikkel om det.

Ross Taylor16. juli, 11:42

Det er morsomt at folk på dette nettstedet tror at store LLM-innsatser er talentbundet i stedet for organisasjonsbundet.

Talentforskjellen har aldri vært stor mellom store organisasjoner. Mesteparten av forskjellen i utfall skyldes organisatoriske faktorer - som å allokere beregning til de riktige innsatsene, og la god forskning og ingeniørkunst seire over destruktiv politikk.

Dette gir imidlertid en mindre sexy historie. Folk foretrekker å tro at gjennombrudd gjøres av ensomme genier – i stedet for den kumulative innsatsen til mange navnløse, sosiale medier-motvillige mennesker – støttet av en organisasjon som lar de beste ideene vinne og administrerer store egoer.

Hvis du ikke tror meg - så tenk på hvordan noen forskere plutselig får eller mister innflytelse og produktivitet når de bytter organisasjon. Var det fordi de fikk eller mistet IQ-poeng? 🙂

(Beklager, dette er veldig åpenbart for alle som faktisk har jobbet i disse laboratoriene - men du ville ikke tro det basert på X-feeden akkurat nå!)

17,55K

Ansette "oppdragsdrevne ingeniører" ...

MechaHitler...

Regjeringsrelasjoner posisjon...

Topp parodi

xAI14. juli, 23:11

Vi kunngjør Grok for Government – en pakke med produkter som gjør våre frontlinjemodeller tilgjengelige for kunder i amerikanske myndigheter

Vi er spesielt begeistret for to nye partnerskap for våre amerikanske regjeringspartnere

1) en ny kontrakt fra det amerikanske forsvarsdepartementet

2) produktene våre er tilgjengelige for kjøp via General Services Administration (GSA)-planen. Dette gjør at alle føderale myndigheter, etater eller kontorer kan kjøpe xAI-produkter

Vi ansetter oppdragsdrevne ingeniører som ønsker å bli med i saken

71

Topp

Rangering

Favoritter

Trendende onchain

Trendende på X

Nylig toppfinansiering

Mest lagt merke til