Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Andrej Karpathy

Costruire @EurekaLabsAI. In precedenza Direttore di AI @ Tesla, team fondatore @ OpenAI, CS231n/PhD @ Stanford. Mi piace addestrare grandi reti 🧠🤖💥 neurali profonde

Modelli video di diffusione ma ora - **in tempo reale**!

I filtri video semplici sono in tempo reale ma possono solo fare una ricollocazione e stili di base. I modelli di diffusione video (Veo e amici) sono magia, ma richiedono molti secondi/minuti per generare. MirageLSD è magia in tempo reale. A differenza dei semplici filtri video, i modelli di diffusione *capiscono* effettivamente cosa stanno guardando, quindi possono stilizzare tutte le parti del feed in modo intelligente (ad esempio, mettere cappelli sulle teste o spade laser nelle mani, ecc.). E sono arbitrariamente guidabili, ad esempio, tramite prompt testuali.

Filtri video personalizzabili e intelligenti sbloccano molte idee interessanti nel tempo:

- trasformare i feed della fotocamera in realtà alternative

- dirigere e girare i propri film, recitando scene con oggetti di scena. In tempo reale => feedback/ripasso istantaneo.

- creare giochi di vibrazione attorno a semplici sfere/blocchi, quindi utilizzare un modello di diffusione in tempo reale per texturizzare il tuo gioco e renderlo bello.

- stilizzare e personalizzare qualsiasi feed video: giochi, video, ... ad esempio Skyrim ma "PIÙ EPICO"? DOOM II ma con qualità moderna di Unreal Engine con solo un prompt? Film horror ma "carino, rosa e solo con coniglietti"? Non lo so!

- sfondi per videochiamate+++

- prova virtuale di vestiti in tempo reale

- occhiali: ad esempio, rendere cartoonistica la tua visione in tempo reale?

- ora possiamo costruire lo Specchio di Erised di Harry Potter, mostrando il "feed grezzo" di te nello specchio ma aumentato con i tuoi desideri più profondi (come inferito dall'IA).

- Non lo so, probabilmente mi manca il più grande, ci sono così tante cose!

Decart18 lug, 04:44

Presentiamo MirageLSD: Il Primo Modello AI di Diffusione in Diretta (LSD)

Inserisci qualsiasi flusso video, da una telecamera o una videochiamata a uno schermo del computer o un videogioco, e trasformalo in qualsiasi mondo tu desideri, in tempo reale (<40ms di latenza).

Ecco come funziona (con demo che puoi utilizzare!) :

326,67K

Spesso mi lamento del fatto che il 99% dell'attenzione sarà rivolta all'attenzione degli LLM invece che a quella umana. Come appare un articolo di ricerca per un LLM invece che per un umano? Di certo non è un pdf. C'è un enorme spazio per un'app di ricerca estremamente preziosa che riesca a capire questo.

Michael Levin10 lug, 22:47

Sono costantemente irritato dal fatto che non ho tempo per leggere il torrente di articoli interessanti che arrivano sempre più velocemente da persone straordinarie nei campi pertinenti. Altri scienziati hanno lo stesso problema e non hanno tempo per leggere la maggior parte dei miei lunghi articoli concettuali. Quindi, per chi stiamo scrivendo questi articoli?

Immagino che, almeno fino a quando non si troveranno di fronte allo stesso problema a causa del loro lavoro, gli AI saranno gli unici ad avere realmente il tempo di leggere tutto questo materiale. Non sto parlando specificamente dei modelli linguistici di oggi - supponiamo di riferirci a qualsiasi AI inevitabile che si presenterà, in grado di leggere la letteratura e avere un impatto sulla ricerca (sia parlando con gli esseri umani che gestendo piattaforme di automazione di laboratorio/scienziati robot).

Quindi: come dovremmo scrivere, sapendo che gran parte del nostro pubblico sarà costituito da AI (più cyborg, ibroti, umani aumentati, ecc.)? Forse è troppo presto per sapere cosa fare, ma è meglio iniziare a pensarci perché assumere che il nostro pubblico sarà sempre composto da esseri umani di oggi sembra insostenibile. Prendendo sul serio l'idea che un giorno il pubblico influente sarà molto diverso, e che le cose che scriviamo ora sono in un certo senso un set di addestramento per esseri futuri veramente diversi, come cambia la nostra scrittura? O non cambia?

498,05K

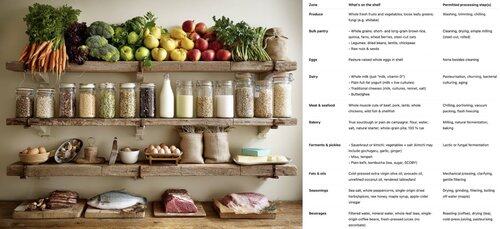

Come costruire una fiorente comunità open source scrivendo codice come fanno i batteri 🦠. Il codice batterico (genomi) è:

- piccolo (ogni riga di codice costa energia)

- modulare (organizzato in gruppi di operoni intercambiabili)

- autonomo (facilmente "copia e incolla" tramite trasferimento orizzontale di geni)

Se i pezzi di codice sono piccoli, modulari, autonomi e banali da copiare e incollare, la comunità può prosperare tramite il trasferimento orizzontale di geni. Per ogni funzione (gene) o classe (operone) che scrivi: riesci a immaginare qualcuno che dice "yoink" senza conoscere il resto del tuo codice o dover importare nulla di nuovo, per ottenere un vantaggio? Il tuo codice potrebbe essere un gist di tendenza su GitHub?

Questa guida di stile di codifica ha permesso ai batteri di colonizzare ogni angolo ecologico, dal freddo al caldo, dall'acido all'alcalino, nelle profondità della Terra e nel vuoto dello spazio, insieme a una diversità pazzesca di anabolismo del carbonio, metabolismo energetico, ecc. Eccelle nel prototipazione rapida ma... non può costruire vita complessa. In confronto, il genoma eucariotico è un monorepo significativamente più grande, più complesso, organizzato e accoppiato. Significativamente meno inventivo ma necessario per la vita complessa - per costruire interi organi e coordinare la loro attività. Con il nostro vantaggio del design intelligente, dovrebbe essere possibile sfruttare entrambi. Costruisci una spina dorsale di monorepo eucariotico se necessario, ma massimizza il DNA batterico.

538,71K

La corsa per il "nucleo cognitivo" LLM - un modello con qualche miliardo di parametri che sacrifica massimamente la conoscenza enciclopedica a favore della capacità. Vive sempre attivo e per impostazione predefinita su ogni computer come il kernel del personal computing LLM.

Le sue caratteristiche si stanno lentamente cristallizzando:

- Multimodale nativo testo/visione/audio sia in input che in output.

- Architettura in stile Matrioska che consente di regolare la capacità su e giù durante il test.

- Ragionamento, anche con un dial. (sistema 2)

- Uso aggressivo degli strumenti.

- Slot LoRA per il fine-tuning on-device per l'addestramento in tempo di test, personalizzazione e customizzazione.

- Delega e verifica solo le parti giuste con gli oracoli nel cloud se è disponibile internet.

Non sa che il regno di Guglielmo il Conquistatore è terminato il 9 settembre 1087, ma riconosce vagamente il nome e può cercare la data. Non può recitare lo SHA-256 della stringa vuota come e3b0c442..., ma può calcolarlo rapidamente se lo desideri davvero.

Ciò che il personal computing LLM manca in conoscenza del mondo e capacità di problem-solving di alto livello, lo compensarà con una latenza di interazione super bassa (soprattutto man mano che il multimodale matura), accesso diretto / privato ai dati e allo stato, continuità offline, sovranità ("non i tuoi pesi, non il tuo cervello"). ossia molte delle stesse ragioni per cui ci piacciono, usiamo e compriamo computer personali invece di avere client leggeri che accedono a un cloud tramite desktop remoto o simili.

1,03M

Principali

Ranking

Preferiti

On-chain di tendenza

Di tendenza su X

Principali fondi recenti

Più popolari