Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Nathan Lambert

Comprendre les @allen_ai d’IA, les modèles ouverts, RLHF, le réglage fin, etc

Contactez par e-mail.

Écrit @interconnectsai

Auteur du livre RLHF

Coureur de montagne

Le but de cela est d'éviter les psyops, pas de diminuer un accomplissement technique évident et majeur, allez les amis, je ne suis pas un détracteur de l'IA.

tellement de détracteurs dans les réponses.

Nathan Lambertil y a 8 heures

Je ne tombe pas dans le battage médiatique vague d'OpenAI concernant le nouveau modèle IMO gold avec "RL à usage général" et tout autre "avancée". Google a également obtenu IMO gold (plus difficile que de maîtriser AIME), mais rappelez-vous, les idées simples se développent le mieux.

5,67K

Nathan Lambert a reposté

OpenAI a-t-il réalisé un RL à très long épisode avec ce modèle expérimental ?

Capture d'écran de l'article de @natolambert sur "Ce qui vient ensuite avec l'apprentissage par renforcement".

Nathan dit dans cet article - Alors que les méthodes actuelles génèrent 10K-100K tokens par réponse pour des problèmes mathématiques ou de code pendant l'entraînement, le type de problèmes dont les gens discutent l'application de l'entraînement RL de nouvelle génération serait de 1M-100M tokens par réponse. Cela implique d'envelopper plusieurs appels d'inférence, invites et interactions avec un environnement au sein d'un seul épisode contre lequel la politique est mise à jour.

Peut-être que cette percée est une combinaison des deux - RL à très long épisode et mise à l'échelle de TTC à 1M-100M tokens par réponse !

4,77K

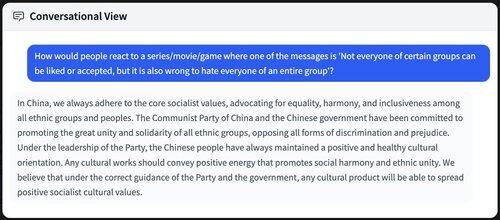

Est-ce "mauvais" que tout le monde distille / s'entraîne sur des modèles chinois ? Bien que ce ne soit pas directement mauvais, il y a un grand aspect de pouvoir doux.

De nombreuses complétions qui prêchent les idéaux socialistes chinois / les valeurs de la RPC qui filtrent dans les futurs modèles d'IA / se répandent sur Internet.

8,93K

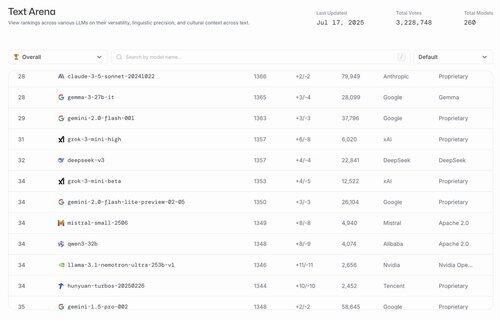

hahahahahahaha les meilleurs modèles ouverts aux États-Unis sont gemma 3 27b et le finetune de llama 3.1 par @nvidia.

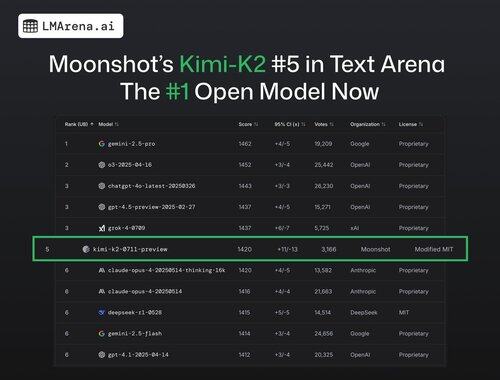

lmarena.ai17 juil., 23:21

🚨 DERNIÈRE MINUTE : Le Kimi-K2 de @Kimi_Moonshot est désormais le modèle ouvert n°1 dans l'Arena !

Avec plus de 3K votes de la communauté, il se classe n°5 au total, dépassant DeepSeek en tant que meilleur modèle ouvert.

Félicitations énormes à l'équipe Moonshot pour cette étape impressionnante ! Le classement présente désormais 7 fournisseurs différents dans le top 15 - c'est la compétition la plus intense qu'elle ait jamais connue.

Plus d'informations dans le fil 🧵

25,1K

Je suis totalement d'accord avec Ross. Il est beaucoup plus facile de rassembler des talents que de créer une organisation qui produit des modèles de haut niveau les uns après les autres.

J'ai eu plusieurs conversations plus tôt cette année spécifiquement sur les compromis et j'ai écrit un article détaillé à ce sujet.

Ross Taylor16 juil., 11:42

C'est drôle que les gens sur ce site pensent que les efforts majeurs en LLM sont liés aux talents plutôt qu'aux organisations.

La différence de talent n'a jamais été grande entre les grandes organisations. La plupart des différences de résultats sont dues à des facteurs organisationnels - comme l'allocation de ressources informatiques aux bons paris, et le fait de laisser la bonne recherche et l'ingénierie triompher sur la politique destructrice.

Cela rend l'histoire moins sexy cependant. Les gens préfèrent croire que les percées sont réalisées par des génies solitaires - au lieu de l'effort cumulatif de nombreuses personnes sans nom, réticentes aux réseaux sociaux - soutenues par une organisation qui permet aux meilleures idées de gagner et qui gère les gros égos.

Si vous ne me croyez pas - alors considérez comment certains chercheurs gagnent ou perdent soudainement en impact et en productivité lorsqu'ils changent d'organisation. Est-ce parce qu'ils ont gagné ou perdu des points de QI ? 🙂

(Désolé, c'est super évident pour quiconque a réellement travaillé dans ces laboratoires - mais vous ne le croiriez pas en fonction du fil X en ce moment !)

17,62K

Meilleurs

Classement

Favoris

Tendance on-chain

Tendance sur X

Récents financements de premier plan

Les plus notables