Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Santiago

Je veux m'assurer que c'est clair :

Lorsque vous rejoignez ma cohorte d'ingénierie AI/ML, vous avez également accès à toutes les futures cohortes.

C'est un accès à vie, donc tant que j'enseigne la cohorte, vous pouvez y participer sans jamais payer un centime de plus.

Il n'y a pas de paiements mensuels. Il n'y a pas de "mises à niveau" ou "ventes additionnelles".

C'est simple : vous payez une fois pour rejoindre, et vous avez accès à *tout*, pour toujours. Pas de limites. Vous devez juste vous présenter en classe quand vous le souhaitez.

Au fait, de nombreux étudiants ont fait cela :

• Ils rejoignent une cohorte pour se réchauffer

• Ils rejoignent la cohorte suivante pour s'investir pleinement

• Ils rejoignent une troisième cohorte avec des super pouvoirs

Bien sûr, c'est optionnel, mais c'est énorme pour ceux d'entre vous qui veulent de la flexibilité.

Ma prochaine cohorte commence dans 2 semaines (le 4 août), et vous pouvez rejoindre en allant sur ml dot school.

3,82K

Je suis allé me coucher hier soir après avoir laissé Gemini faire des recherches approfondies sur quelques services à domicile dont j'ai besoin.

Je me suis réveillé aujourd'hui avec des jours de travail prêts pour moi. La profondeur de l'analyse était "putain, c'est génial !"

Je ne pense pas que nous comprenions. Je ne pense pas que nous soyons prêts.

10,27K

Je ne suis plus sûr de ce que je pense de ce livre.

C'était un livre fantastique à une époque où la plupart de ces idées semblaient précieuses, mais il est aussi responsable de certaines des plus grandes atrocités que j'ai vues.

Je ne recommande plus aux gens de le lire. Je ne l'ai pas fait depuis un moment.

28,72K

Voici comment vous pouvez écrire un code 10 fois meilleur avec 10 fois moins d'effort.

Des agents personnalisés et spécialisés examinent votre code à chaque étape.

J'ai déjà vu des revues de code automatisées, mais jamais avec la possibilité de définir vos propres agents réviseurs. @baz_scm est le premier à réaliser cela, et c'est plutôt cool.

Il existe trois types d'agents réviseurs :

1. Ceux qui sont prêts à l'emploi.

Ces agents couvrent les modèles les plus courants que tout le monde souhaite vérifier : code dupliqué, code cassé, code complexe, etc.

2. Des agents réviseurs recommandés que Baz crée automatiquement pour vous.

Baz analyse votre historique de révisions et vos commentaires passés pour identifier les modèles qui vous intéressent, puis crée automatiquement des agents spécialisés dans la vérification de ces modèles.

Par exemple, si vous demandez toujours à vos développeurs de garder les fichiers en dessous de 100 lignes de code, Baz le détectera et créera un agent personnalisé qui vérifie cela.

3. Des agents réviseurs personnalisés que vous définissez.

Ce sont mes préférés : écrivez une invite expliquant vos règles, et votre agent commencera à vérifier votre code pour signaler tout ce qui correspond aux règles.

J'ai créé un simple agent réviseur dans la vidéo jointe.

Honnêtement, à ce stade, vous n'avez plus d'excuse pour expédier du mauvais code.

Voici un lien pour essayer ces agents réviseurs personnalisés :

Merci à l'équipe @baz_scm pour avoir collaboré avec moi sur ce post.

31,45K

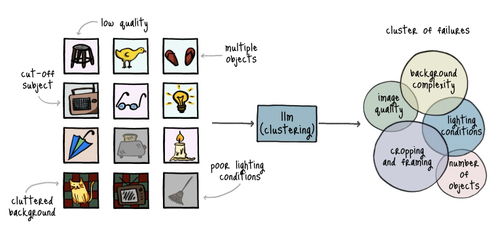

Honnêtement, la plupart des développeurs d'IA sont encore coincés dans le siècle dernier.

Ça me sidère de voir combien de personnes sont conscientes de l'Analyse des Erreurs.

C'est *littéralement* la manière la plus rapide et la plus efficace d'évaluer les applications d'IA, et la plupart des équipes sont encore en train de poursuivre des fantômes.

S'il vous plaît, arrêtez de suivre des métriques génériques et suivez ces étapes :

1. Collectez des échantillons d'échec

Commencez à examiner les réponses générées par votre application. Prenez des notes sur chaque réponse, en particulier celles qui étaient des erreurs. Vous n'avez pas besoin de formater vos notes d'une manière spécifique. Concentrez-vous sur la description de ce qui a mal tourné avec la réponse.

2. Catégorisez vos notes

Après avoir examiné un bon ensemble de réponses, prenez un LLM et demandez-lui de trouver des motifs communs dans vos notes. Demandez-lui de classer chaque note en fonction de ces motifs.

Vous obtiendrez des catégories couvrant chaque type d'erreur que votre application a commise.

3. Diagnostiquez les erreurs les plus fréquentes

Commencez par vous concentrer sur le type d'erreur le plus courant. Vous ne voulez pas perdre de temps à travailler sur des erreurs rares.

Plongez dans les conversations, les entrées et les journaux menant à ces échantillons incorrects. Essayez de comprendre ce qui pourrait causer les problèmes.

4. Concevez des corrections ciblées

À ce stade, vous voulez déterminer comment éliminer les erreurs que vous avez diagnostiquées à l'étape précédente aussi rapidement et aussi économiquement que possible.

Par exemple, vous pourriez ajuster vos invites, ajouter des règles de validation supplémentaires, trouver plus de données d'entraînement ou modifier le modèle.

5. Automatisez le processus d'évaluation

Vous devez mettre en œuvre un processus simple pour relancer un ensemble d'évaluation à travers votre application et évaluer si vos corrections ont été efficaces.

Ma recommandation est d'utiliser un LLM-en-tant-que-Juge pour faire passer des échantillons à travers l'application, les noter avec une étiquette PASS/FAIL, et calculer les résultats.

6. Gardez un œil sur vos métriques

Chaque catégorie que vous avez identifiée lors de l'analyse des erreurs est une métrique que vous souhaitez suivre dans le temps.

Vous n'irez nulle part en vous obsédant sur "la pertinence", "la justesse", "l'exhaustivité", "la cohérence", et toute autre métrique standard. Oubliez cela et concentrez-vous sur les véritables problèmes que vous avez trouvés.

49,31K

Meilleurs

Classement

Favoris

Tendance on-chain

Tendance sur X

Récents financements de premier plan

Les plus notables