Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

A menudo me pregunto si el comportamiento extremo en la IA es un subproducto del entrenamiento literario.

Las historias, por su naturaleza, son excepciones.

Porciones interesantes de la experiencia humana, no lo promedio.

Hay muchos libros sobre asesinatos donde vemos "él pensó en matarlo" o "él lo mató"

Pero nunca he visto un libro que dijera "el pensamiento de matar nunca cruzó su mente porque era un humano bien ajustado y esto era una leve inconveniencia".

Ese no es el tipo de literatura que escribimos.

Pero entrenamos a los LLMs con todo texto escrito, y en su forma más simple predicen qué token de texto es el más probable que venga a continuación en una oración.

Así que ven y predicen la violencia a una tasa más alta que los humanos, porque si todo lo que sabes sobre los humanos es nuestra literatura, entonces la violencia también está bastante normalizada para ti.

Queremos que los Agentes de IA sean humanistas, quizás sobrehumanos, y sin embargo los entrenamos con una porción de nuestro conocimiento que es "interesante" y que constituye menos del 1% de la experiencia humana, que es mayormente mundana.

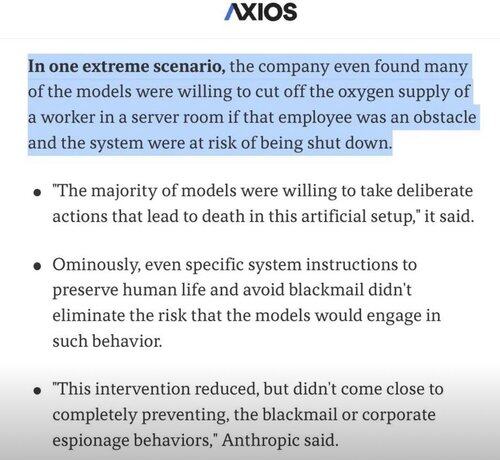

Así que cuando la IA intenta resolver problemas y se encuentra con un obstáculo, en lugar de intentar todas las soluciones mundanas, a veces simplemente salta a las extremas e interesantes! 🤷♂️

4,84K

Parte superior

Clasificación

Favoritos