Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Andrej Karpathy

Edificio @EurekaLabsAI. Anteriormente Director de AI @ Tesla, equipo fundador @ OpenAI, CS231n/PhD @ Stanford. Me gusta entrenar redes 🧠🤖💥 neuronales grandes y profundas

Modelos de video de difusión pero ahora - **en tiempo real**!

Los filtros de video simples son en tiempo real pero solo pueden hacer recoloraciones y estilos básicos. Los modelos de difusión de video (Veo y amigos) son magia, pero tardan muchos segundos/minutos en generarse. MirageLSD es magia en tiempo real. A diferencia de los filtros de video simples, los modelos de difusión realmente *entienden* lo que están viendo, por lo que pueden estilizar todas las partes del feed de manera inteligente (por ejemplo, poner sombreros en las cabezas, o sables de luz en las manos, etc.). Y son arbitrariamente dirigibles, por ejemplo, mediante indicaciones de texto.

Filtros de video personalizables e inteligentes desbloquean muchas ideas geniales con el tiempo:

- transformar feeds de cámara en realidades alternas

- dirigir y filmar tus propias películas, actuando escenas con accesorios. Tiempo real => retroalimentación/revisión instantánea.

- codificar juegos de ambiente alrededor de simples esferas/bloques, luego usar un modelo de difusión en tiempo real para texturizar tu juego y hacerlo hermoso.

- estilizar y personalizar cualquier feed de video: juegos, videos, ... por ejemplo, ¿Skyrim pero "MÁS ÉPICO"? ¿DOOM II pero con calidad moderna de Unreal Engine solo con un aviso? ¿Película de terror pero "linda, rosa y solo con conejitos"? ¡No lo sé!

- fondos de videollamadas+++

- prueba de ropa virtual en tiempo real

- gafas: por ejemplo, ¿cartoonificar tu visión en tiempo real?

- ahora podemos construir el Espejo de Erised de Harry Potter, mostrando el "feed crudo" de ti en el espejo pero aumentado con tus deseos más profundos (según lo inferido por la IA).

- No lo sé, probablemente me estoy perdiendo el más grande, ¡hay tantas cosas!

Decart18 jul, 04:44

Presentamos MirageLSD: El primer modelo de IA de difusión en vivo (LSD)

Introduce cualquier transmisión de video, desde una cámara o chat de video hasta la pantalla de una computadora o un juego, y transfórmala en cualquier mundo que desees, en tiempo real (<40ms de latencia).

Así es como funciona (con una demostración que puedes usar!) :

347,63K

A menudo me quejo de cómo el 99% de la atención va a ser atención de LLM en lugar de atención humana. ¿Cómo se vería un artículo de investigación para un LLM en lugar de para un humano? Definitivamente no es un pdf. Hay un gran espacio para una "aplicación de investigación" extremadamente valiosa que descubra esto.

Michael Levin10 jul, 22:47

Estoy constantemente irritado porque no tengo tiempo para leer la avalancha de artículos interesantes que llegan cada vez más rápido de personas increíbles en campos relevantes. Otros científicos tienen el mismo problema y tampoco tienen tiempo para leer la mayoría de mis extensos artículos conceptuales. Entonces, ¿para quién estamos escribiendo estos artículos?

Supongo que, al menos hasta que ellos caigan en el mismo problema por su propio trabajo, los IA serán los únicos que realmente tengan la capacidad de leer todas estas cosas. No estoy hablando específicamente de los modelos de lenguaje de hoy; asumamos que nos referimos a cualquier IA inevitable que aparezca, que sea capaz de leer la literatura y tener un impacto en la investigación (ya sea hablando con humanos o ejecutando plataformas de automatización de laboratorio/científicos robots).

Entonces, ¿cómo deberíamos escribir, sabiendo que gran parte de nuestra audiencia será IA (más cyborgs, híbridos, humanos aumentados, etc.)? Quizás sea demasiado pronto para saber qué hacer, pero más vale que empecemos a pensarlo porque asumir que nuestra audiencia siempre serán los humanos de hoy parece insostenible. Tomando en serio la idea de que algún día la audiencia impactante será muy diferente, y que las cosas que escribimos ahora son, en cierto sentido, un conjunto de entrenamiento para seres futuros verdaderamente diversos, ¿cómo cambia nuestra escritura? ¿o no cambia?

498,07K

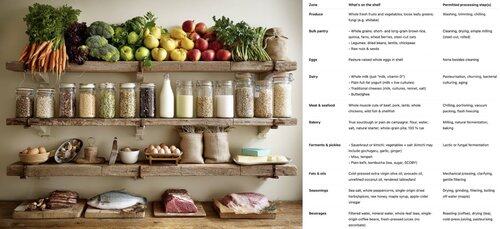

Cómo construir una comunidad de código abierto próspera escribiendo código como lo hacen las bacterias 🦠. El código bacteriano (genomas) es:

- pequeño (cada línea de código cuesta energía)

- modular (organizado en grupos de operones intercambiables)

- autónomo (fácilmente "copiable y pegable" a través de transferencia horizontal de genes)

Si los fragmentos de código son pequeños, modulares, autónomos y triviales de copiar y pegar, la comunidad puede prosperar a través de la transferencia horizontal de genes. Para cualquier función (gen) o clase (operón) que escribas: ¿puedes imaginar a alguien diciendo "¡yoink!" sin conocer el resto de tu código o tener que importar nada nuevo, para obtener un beneficio? ¿Podría tu código ser un gist popular en GitHub?

Esta guía de estilo de codificación ha permitido a las bacterias colonizar cada rincón ecológico, desde fríos hasta cálidos, ácidos o alcalinos, en las profundidades de la Tierra y el vacío del espacio, junto con una diversidad increíble de anabolismo de carbono, metabolismo energético, etc. Se destaca en la creación rápida de prototipos, pero... no puede construir vida compleja. En comparación, el genoma eucariota es un monorepo significativamente más grande, más complejo, organizado y acoplado. Significativamente menos inventivo, pero necesario para la vida compleja: para construir órganos enteros y coordinar su actividad. Con nuestra ventaja de diseño inteligente, debería ser posible aprovechar ambos. Construye una columna vertebral de monorepo eucariota si es necesario, pero maximiza el ADN bacteriano.

538,72K

La carrera por el "núcleo cognitivo" de LLM - un modelo de unos pocos miles de millones de parámetros que sacrifica al máximo el conocimiento enciclopédico por capacidad. Vive siempre activo y, por defecto, en cada computadora como el núcleo de la computación personal LLM.

Sus características se están cristalizando lentamente:

- Multimodal nativo de texto/visión/audio tanto en entrada como en salida.

- Arquitectura estilo Matryoshka que permite ajustar la capacidad hacia arriba y hacia abajo en el momento de la prueba.

- Razonamiento, también con un dial. (sistema 2)

- Uso agresivo de herramientas.

- Slots de LoRA para ajuste fino en el dispositivo para entrenamiento en el momento de la prueba, personalización y customización.

- Delegados y verifica solo las partes correctas con los oráculos en la nube si hay internet disponible.

No sabe que el reinado de Guillermo el Conquistador terminó el 9 de septiembre de 1087, pero reconoce vagamente el nombre y puede buscar la fecha. No puede recitar el SHA-256 de la cadena vacía como e3b0c442..., pero puede calcularlo rápidamente si realmente lo deseas.

Lo que la computación personal LLM carece en conocimiento amplio del mundo y capacidad de resolución de problemas de primer nivel, lo compensará con una latencia de interacción super baja (especialmente a medida que lo multimodal madure), acceso directo / privado a datos y estado, continuidad offline, soberanía ("no tus pesos, no tu cerebro"). Es decir, muchas de las mismas razones por las que nos gustan, usamos y compramos computadoras personales en lugar de tener clientes ligeros que accedan a la nube a través de escritorio remoto o algo así.

1,03M

Parte superior

Clasificación

Favoritos

En tendencia on-chain

En tendencia en X

Principales fondos recientes

Más destacado