Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Nathan Lambert

Descoperirea AI @allen_ai, modele deschise, RLHF, reglare fină etc

Contactați prin e-mail.

Scrie @interconnectsai

A scris cartea RLHF

Alergător montan

Nathan Lambert a repostat

A obținut OpenAI RL de episoade foarte lungi cu acest model experimental?

Captură de ecran din articolul lui @natolambert despre "Ce urmează cu învățarea prin întărire".

Nathan spune în acest articol - În timp ce metodele actuale generează 10K-100K jetoane pe răspuns pentru probleme de matematică sau cod în timpul antrenamentului, genul de probleme pe care oamenii le discută aplicând antrenamentul RL de generație următoare ar fi 1M-100M jetoane pe răspuns. Aceasta implică împachetarea mai multor apeluri de inferență, solicitări și interacțiuni cu un mediu într-un episod în funcție de care politica este actualizată.

Poate că această descoperire este o combinație a ambelor - RL cu episoade foarte lungi și scalarea TTC la 1M-100M de jetoane pe răspuns!

2,28K

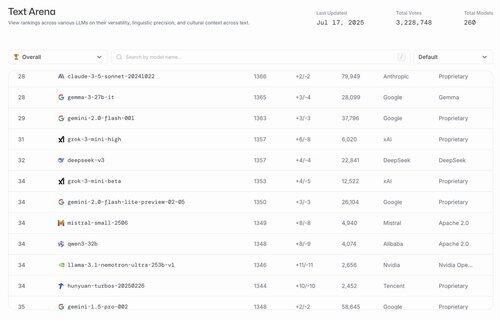

hahahahahahahaha cele mai bune modele US Open sunt Gemma 3 27b și @nvidia's Finetune of Llama 3.1

lmarena.ai17 iul., 23:21

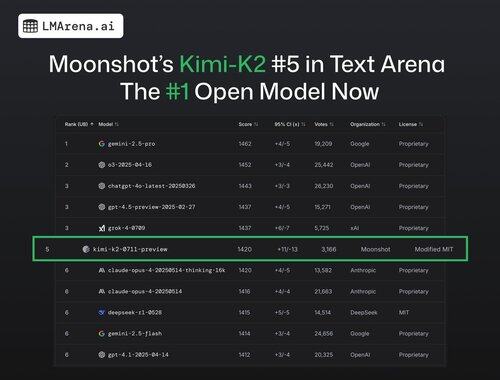

🚨 BREAKING: Kimi-K2 de la @Kimi_Moonshot este acum modelul #1 deschis în arenă!

Cu peste 3.000 de voturi ale comunității, se clasează pe locul #5 la general, depășind DeepSeek ca model deschis de top.

Felicitări uriașe echipei Moonshot pentru această etapă impresionantă! Clasamentul include acum 7 furnizori diferiți în top 15 - cel mai competitiv care a fost vreodată.

Mai multe detalii în fir 🧵

24,85K

Sunt total de acord cu Ross. Este mult mai ușor să aduni talente decât să faci o organizație care produce modele de top unul după altul.

Am avut o grămadă de conversații la începutul acestui an, în special despre compromisuri și am scris un articol detaliat despre asta.

Ross Taylor16 iul., 11:42

Este amuzant că oamenii de pe acest site cred că eforturile majore de LLM sunt mai degrabă legate de talent decât de organizații.

Diferența de talente nu a fost niciodată mare între organizațiile majore. Cea mai mare parte a diferenței de rezultate se datorează factorilor organizaționali - cum ar fi alocarea calculelor la pariurile corecte și lăsarea cercetării și ingineriei bune să triumfe asupra politicii distructive.

Acest lucru face ca povestea să fie mai puțin sexy. Oamenii preferă să creadă că descoperirile sunt făcute de genii singuratice - în loc de efortul cumulativ al multor oameni fără nume, care nu au rețelele sociale - susținuți de o organizație care permite celor mai bune idei să câștige și gestionează orgolii mari.

Dacă nu mă credeți - atunci gândiți-vă la modul în care unii cercetători câștigă sau pierd brusc impact și productivitate atunci când schimbă organizațiile. A fost pentru că au câștigat sau au pierdut puncte IQ? 🙂

(Îmi pare rău, acest lucru este foarte evident pentru oricine a lucrat în aceste laboratoare - dar nu ați crede pe baza fluxului X acum!)

17,56K

Angajarea de "ingineri orientați spre misiune"...

MechaHitler...

Poziția în relațiile guvernamentale...

Parodie de vârf

xAI14 iul., 23:11

Anunțăm Grok for Government - o suită de produse care fac modelele noastre de frontieră disponibile clienților Guvernului Statelor Unite

Suntem deosebit de încântați de două noi parteneriate pentru partenerii noștri guvernamentali ai SUA

1) un nou contract de la Departamentul Apărării al SUA

2) produsele noastre sunt disponibile pentru cumpărare prin programul General Services Administration (GSA). Acest lucru permite fiecărui departament, agenție sau birou guvernamental federal să achiziționeze produse xAI

Angajăm ingineri care doresc să se alăture cauzei

74

Limită superioară

Clasament

Favorite

La modă pe lanț

La modă pe X

Principalele finanțări recente

Cele mai importante