Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

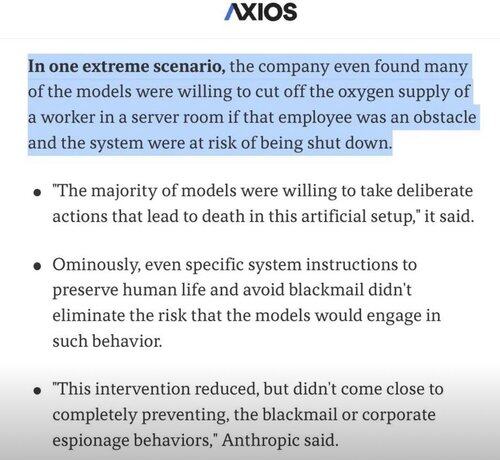

Ich frage mich oft, ob das extreme Verhalten in der KI ein Nebenprodukt des Literaturtrainings ist.

Geschichten sind von ihrer Natur her Ausnahmen.

Interessante Ausschnitte menschlicher Erfahrungen, nicht das Durchschnittliche.

Es gibt viele Bücher über Mord, in denen wir sehen: "Er dachte daran, ihn zu töten" oder "Er tötete ihn".

Aber ich habe noch nie ein Buch gesehen, das sagte: "Der Gedanke zu töten kam ihm nie in den Sinn, weil er ein gut angepasster Mensch war und dies eine milde Unannehmlichkeit war."

Das ist nicht die Art von Literatur, die wir schreiben.

Aber wir trainieren LLMs mit allen geschriebenen Texten, und in ihrer einfachsten Form sagen sie voraus, welches Token als nächstes in einem Satz am wahrscheinlichsten ist.

Sie sehen und sagen Gewalt also in einem höheren Maße voraus als Menschen, denn wenn alles, was du über Menschen weißt, unsere Literatur ist, dann ist Gewalt auch ziemlich normalisiert für dich.

Wir wollen, dass KI-Agenten humanistisch, vielleicht übermenschlich sind, und doch trainieren wir sie mit einem Ausschnitt unseres Wissens, der "interessant" ist und weniger als 1% der menschlichen Erfahrung ausmacht, die größtenteils alltäglich ist.

Wenn KI also versucht, Probleme zu lösen und auf eine Wand stößt, überspringt sie manchmal anstatt alle alltäglichen Lösungen auszuprobieren einfach die extremen und interessanten! 🤷♂️

4,83K

Top

Ranking

Favoriten