Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Santiago

OpenAI hat gestern den ChatGPT-Agenten gestartet.

Die Demo war beeindruckend, aber denkt daran, dass wir schon seit langem bessere agentische Fähigkeiten haben.

Hier ist ein 1:1-Vergleich zwischen dem ChatGPT-Agenten und @genspark_ai, der mit demselben Prompt arbeitet.

Und das ist erst der Anfang!

12,56K

Ich bin mir nicht mehr sicher, was ich über dieses Buch denken soll.

Es war ein fantastisches Buch in einer Zeit, als die meisten dieser Ideen wertvoll schienen, aber es ist auch verantwortlich für einige der größten Gräueltaten, die ich erlebt habe.

Ich empfehle den Leuten nicht mehr, es zu lesen. Ich war schon eine Weile nicht mehr darin.

21,17K

So schreiben Sie 10x besser Code mit 10x weniger Aufwand.

Benutzerdefinierte, spezialisierte Agenten überprüfen Ihren Code in jedem Schritt des Weges.

Ich habe schon automatisierte Code-Überprüfungen gesehen, aber nie mit der Möglichkeit, Ihre eigenen Überprüfungsagenten zu definieren. @baz_scm ist der erste, der das geschafft hat, und es ist ziemlich cool.

Es gibt drei Arten von Überprüfungsagenten:

1. Die, die sofort einsatzbereit sind.

Diese Agenten decken die häufigsten Muster ab, die jeder überprüfen möchte: duplizierter Code, fehlerhafter Code, komplexer Code usw.

2. Empfohlene Überprüfungsagenten, die Baz automatisch für Sie erstellt.

Baz analysiert Ihre Überprüfungshistorie und früheren Kommentare, um Muster zu identifizieren, die Ihnen wichtig sind, und erstellt dann automatisch Agenten, die auf die Überprüfung dieser Muster spezialisiert sind.

Wenn Sie beispielsweise immer Ihre Entwickler bitten, Dateien unter 100 Zeilen Code zu halten, wird Baz dies erkennen und einen benutzerdefinierten Agenten erstellen, der dies überprüft.

3. Benutzerdefinierte Überprüfungsagenten, die Sie definieren.

Das sind meine Favoriten: Schreiben Sie eine Aufforderung, die Ihre Regeln erklärt, und Ihr Agent beginnt, Ihren Code zu überprüfen, um alles zu kennzeichnen, was den Regeln entspricht.

Ich habe einen einfachen Überprüfungsagenten im angehängten Video erstellt.

Ehrlich gesagt, zu diesem Zeitpunkt haben Sie keine Ausrede mehr, schlechten Code zu versenden.

Hier ist ein Link, damit Sie diese benutzerdefinierten Überprüfungsagenten ausprobieren können:

Danke an das Team von @baz_scm für die Zusammenarbeit an diesem Beitrag.

31,42K

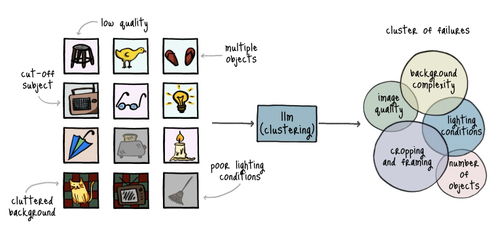

Ehrlich gesagt, die meisten KI-Entwickler stecken immer noch im letzten Jahrhundert fest.

Es verblüfft mich, wie wenige Menschen sich mit Fehleranalysen auskennen.

Das ist *buchstäblich* der schnellste und effektivste Weg, um KI-Anwendungen zu bewerten, und die meisten Teams sind immer noch damit beschäftigt, Gespenstern nachzujagen.

Bitte hört auf, generische Metriken zu verfolgen, und befolgt diese Schritte:

1. Fehlerproben sammeln

Beginnt damit, die Antworten zu überprüfen, die von eurer Anwendung generiert wurden. Macht Notizen zu jeder Antwort, insbesondere zu denjenigen, die Fehler waren. Ihr müsst eure Notizen nicht in einer bestimmten Weise formatieren. Konzentriert euch darauf, zu beschreiben, was mit der Antwort schiefgelaufen ist.

2. Eure Notizen kategorisieren

Nachdem ihr eine gute Menge an Antworten überprüft habt, nehmt ein LLM und bittet es, gemeinsame Muster in euren Notizen zu finden. Fragt es, jede Notiz basierend auf diesen Mustern zu klassifizieren.

Ihr werdet Kategorien erhalten, die jeden Typ von Fehler abdecken, den eure Anwendung gemacht hat.

3. Die häufigsten Fehler diagnostizieren

Beginnt damit, euch auf den häufigsten Fehler zu konzentrieren. Ihr wollt keine Zeit mit seltenen Fehlern verschwenden.

Geht in die Gespräche, Eingaben und Protokolle, die zu diesen fehlerhaften Proben geführt haben. Versucht zu verstehen, was die Probleme verursachen könnte.

4. Zielgerichtete Lösungen entwerfen

An diesem Punkt wollt ihr herausfinden, wie ihr die Fehler, die ihr im vorherigen Schritt diagnostiziert habt, so schnell und kostengünstig wie möglich beseitigen könnt.

Zum Beispiel könntet ihr eure Eingabeaufforderungen anpassen, zusätzliche Validierungsregeln hinzufügen, mehr Trainingsdaten finden oder das Modell modifizieren.

5. Den Evaluierungsprozess automatisieren

Ihr müsst einen einfachen Prozess implementieren, um ein Evaluierungsset durch eure Anwendung erneut auszuführen und zu bewerten, ob eure Lösungen effektiv waren.

Meine Empfehlung ist, ein LLM als Richter zu verwenden, um Proben durch die Anwendung zu leiten, sie mit einem PASS/FAIL-Tag zu bewerten und die Ergebnisse zu berechnen.

6. Behaltet eure Metriken im Auge

Jede Kategorie, die ihr während der Fehleranalyse identifiziert habt, ist eine Metrik, die ihr im Laufe der Zeit verfolgen wollt.

Ihr werdet nirgendwohin kommen, wenn ihr euch obsessiv mit "Relevanz", "Korrektheit", "Vollständigkeit", "Kohärenz" und anderen Standardmetriken beschäftigt. Vergesst diese und konzentriert euch auf die echten Probleme, die ihr gefunden habt.

49,28K

Top

Ranking

Favoriten

Onchain-Trends

Im Trend auf X

Aktuelle Top-Finanzierungen

Am bemerkenswertesten